En la versión más reciente de su política de uso, OpenAI ya no incluye la cláusula que restringía expresamente la utilización de sus tecnologías para propósitos bélicos o militares. Antes, las regulaciones de la compañía especificaban claramente una prohibición sobre el empleo de sus productos en el ámbito militar.

Asimismo, eliminó el ítem donde se mencionaba su uso en la “gestión u operación de infraestructuras críticas en energía, transporte y agua”.

En la anterior versión de sus políticas de uso decía:

“Uso no permitido de nuestros modelos. No permitimos el uso de nuestros modelos para lo siguiente: Actividades que tienen un alto riesgo de daño físico, incluyendo: – Desarrollo de armas – Militar y guerra – Gestión u operación de infraestructuras críticas en energía, transporte y agua. – Contenido que promueva, fomente o represente actos de autolesión, como suicidio, cortes y trastornos alimentarios”.

:quality(85)/cloudfront-us-east-1.images.arcpublishing.com/infobae/YZSGQTHJDZD77HU2EOY2SYWWYY.jpg 420w) La nueva normativa de OpenAI no delimita explícitamente la aplicación de tecnologías en propósitos bélicos. (Imagen ilustrativa Infobae)

La nueva normativa de OpenAI no delimita explícitamente la aplicación de tecnologías en propósitos bélicos. (Imagen ilustrativa Infobae)Mientras que, en las actuales políticasdel 10 de enero de 2024, en la página web de la empresa, dicen:

“No utilice nuestro servicio para hacerse daño a sí mismo o a otros; por ejemplo, no utilice nuestros servicios para promover el suicidio o la autolesión, desarrollar o utilizar armas, herir a otros o destruir propiedad, ni participar en actividades no autorizadas que violen la seguridad de cualquier servicio o sistema”.

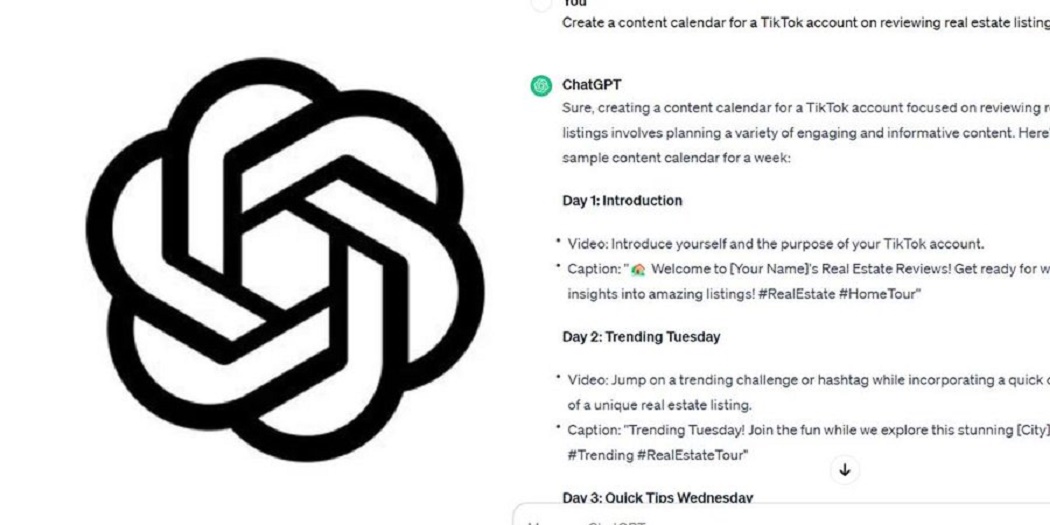

El cambio en la política de uso de OpenAI fue detectado inicialmente por The Intercept, quienes establecieron contacto con la compañía para obtener más detalles.

Un representante de OpenAI, Niko Felix, respondió al medio citado por correo electrónico, aclarando que el objetivo de la empresa “era crear un conjunto de principios universales que fueran fáciles de recordar y aplicar, especialmente porque nuestras herramientas ahora son utilizadas globalmente por usuarios cotidianos que ahora también pueden construir GPT”.

:quality(85)/cloudfront-us-east-1.images.arcpublishing.com/infobae/IV7QW5ATURBPNJV6NB3MP5D3UU.jpg 420w) Niko Felix de OpenAI explica que buscan principios fáciles de recordar y aplicar globalmente por los usuarios. (Imagen ilustrativa Infobae)

Niko Felix de OpenAI explica que buscan principios fáciles de recordar y aplicar globalmente por los usuarios. (Imagen ilustrativa Infobae)Continuó explicando la intención de la empresa: “un principio como ‘No dañar a los demás’ es amplio pero fácil de entender y relevante en numerosos contextos”. Felix también remarcó, “además, citamos específicamente las armas y las lesiones a otros como ejemplos claros”.

Felix igualmente escribió en dicho correo que “cualquier uso de nuestra tecnología, incluso por parte del ejército, para desarrollar o usar armas, herir a otros o destruir propiedad, o participar en actividades no autorizadas que violen la seguridad de cualquier servicio o sistema’, no está permitido”.

Heidy Khlaaf, directora de ingeniería en la empresa de ciberseguridad Trail of Bits y especialista en aprendizaje automático y la seguridad de sistemas autónomos, expresó al medio su preocupación acerca de los potenciales riesgos y daños que podrían derivar del empleo de la tecnología y servicios de OpenAI en contextos militares.

:quality(85)/cloudfront-us-east-1.images.arcpublishing.com/infobae/EHBCUNWSGRE6HL5C4BX7O4OXPY.png 992w) Las políticas antiguas señalaban por ítems cada uso no permitido. (OpenAI)

Las políticas antiguas señalaban por ítems cada uso no permitido. (OpenAI)Khlaaf hizo referencia a un artículo de 2022, en el cual colaboró con investigadores de OpenAI, donde se destaca específicamente el peligro de su uso en aplicaciones militares. Ella observó un cambio en la política de la compañía que, a su parecer, prioriza la legalidad sobre la seguridad.

Según la experta, “existe una clara diferencia entre las dos políticas, ya que la primera describe claramente que el desarrollo de armas y el ejército y la guerra no están permitidos, mientras que la segunda enfatiza la flexibilidad y el cumplimiento de la ley”.

Puso de manifiesto que, dado que el desarrollo de armamento y las actividades bélicas pueden ser legales, esto no disminuye las posibles consecuencias graves para la seguridad de la inteligencia artificial.

:quality(85)/cloudfront-us-east-1.images.arcpublishing.com/infobae/B5CV2JO7UJD3RPRXY4B5ECQLG4.png 992w) Las políticas actuales utilizan un lenguaje más general. (OpenAI)

Las políticas actuales utilizan un lenguaje más general. (OpenAI)Resaltó las preocupaciones existentes sobre los prejuicios y errores de los modelos de lenguaje de gran escala y advirtió que su aplicación en contextos bélicos podría resultar en operaciones imprecisas y sesgadas con un incremento posible en el daño y el número de víctimas civiles.